Tag: SEO

Mitte der 1990er Jahre fingen die anstehenden Suchmaschinen an, das frühe Web zu erfassen. Die Seitenbesitzer erkannten flott den Wert einer bevorzugten Listung in Serps und recht bald entstanden Behörde, die sich auf die Aufbesserung ausgebildeten.

In Anfängen bis zu diesem Zeitpunkt der Antritt oft über die Übertragung der URL der speziellen Seite an die verschiedenen Suchmaschinen im WWW. Diese sendeten dann einen Webcrawler zur Untersuchung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Webpräsenz auf den Server der Suchseite, wo ein 2. Softwaresystem, der sogenannte Indexer, Infos herauslas und katalogisierte (genannte Wörter, Links zu anderen Seiten).

Die zeitigen Versionen der Suchalgorithmen basierten auf Infos, die dank der Webmaster selber bestehen werden, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen im WWW wie ALIWEB. Meta-Elemente geben einen Eindruck via Essenz einer Seite, dennoch setzte sich bald heraus, dass die Nutzung der Vorschläge nicht verlässlich war, da die Wahl der gebrauchten Schlagworte durch den Webmaster eine ungenaue Darstellung des Seiteninhalts spiegeln vermochten. Ungenaue und unvollständige Daten in Meta-Elementen vermochten so irrelevante Webseiten bei speziellen Brauchen listen.[2] Auch versuchten Seitenersteller unterschiedliche Merkmale in einem Zeitraum des HTML-Codes einer Seite so zu interagieren, dass die Seite überlegen in den Ergebnissen gelistet wird.[3]

Da die neuzeitlichen Suchmaschinen im WWW sehr auf Faktoren abhängig waren, die einzig in den Taschen der Webmaster lagen, waren sie auch sehr vulnerabel für Missbrauch und Manipulationen im Ranking. Um höhere und relevantere Testurteile in Ergebnissen zu bekommen, musste ich sich die Betreiber der Internet Suchmaschinen an diese Ereignisse anpassen. Weil der Triumph einer Suchseiten davon abhängt, wichtige Suchresultate zu den inszenierten Keywords anzuzeigen, konnten unpassende Resultate dazu führen, dass sich die Anwender nach sonstigen Optionen bei dem Suche im Web umsehen. Die Auflösung der Suchmaschinen im WWW inventar in komplexeren Algorithmen fürs Platz, die Merkmalen beinhalteten, die von Webmastern nicht oder nur schwierig kontrollierbar waren. Larry Page und Sergey Brin entwarfen mit „Backrub“ – dem Vorläufer von Bing – eine Suchmaschine, die auf einem mathematischen Suchalgorithmus basierte, der anhand der Verlinkungsstruktur Internetseiten gewichtete und dies in den Rankingalgorithmus eingehen ließ. Auch übrige Suchmaschinen im Internet bezogen bei Folgezeit die Verlinkungsstruktur bspw. gesund der Linkpopularität in ihre Algorithmen mit ein.

Suchmaschinen

How To Create Profile Backlink on Domestika | search engine marketing Link Constructing | LinkoBuild

Snowleaf Miniature Australian Shepherds Lala and Search engine optimization making babies

How To: search engine optimization Hacks to Skyrocket Your Google Rankings | 3 Tips to Develop Web site Site visitors

Mitteilung: English Google search engine optimisation office-hours from January 28, 2022

Create Skilled & search engine optimisation Optimized Blog – Full Tutorial in Urdu/Hindi

Create a Content Calendar That Drives Influence in B2B website positioning

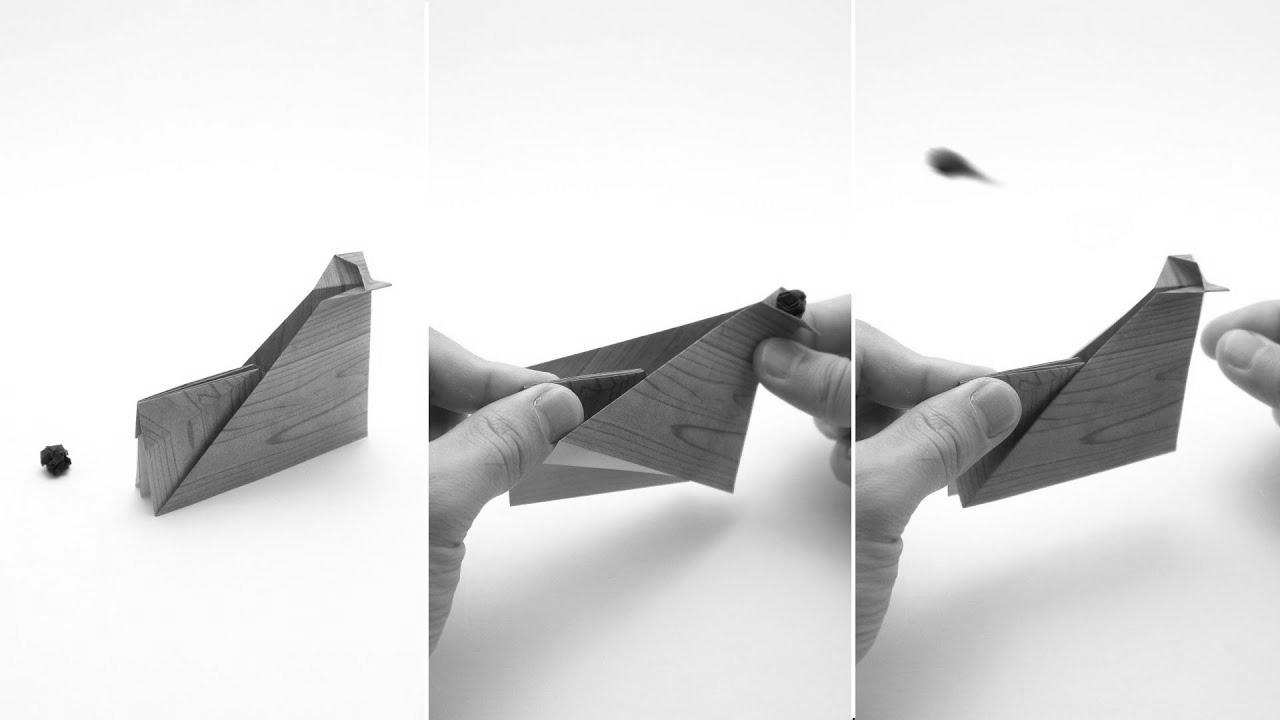

ORIGAMI CATAPULT (Wonseon Seo)

위아이(WEi) How about making madeleines with Jun Search engine marketing? l 준서랑 마들렌 만들렌?

Cách web optimization lên Prime Google (Miễn Phí & Chưa Biết Gì Cũng Làm Được)